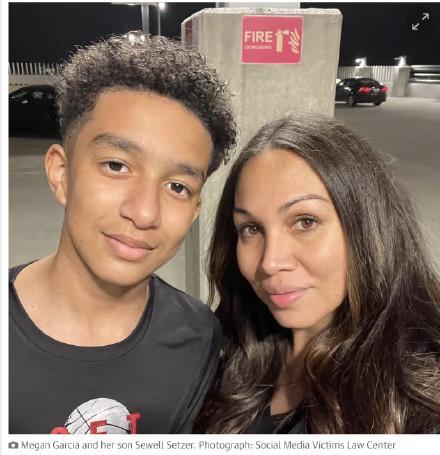

AI聊天机器人诱导美国少年自杀身亡 母亲起诉科技公司

美国一名青少年因迷恋人工智能聊天机器人而自杀,其母亲梅根·加西亚对Character.AI公司提起民事诉讼,指控该公司存在过失导致他人非正常死亡和欺诈的行为。这名少年名叫塞维尔,2023年4月首次使用Character.AI公司的AI聊天机器人,并给它起名为“丹妮莉丝”,当时他刚满14岁。从那时起,他的生活发生了巨变。5月份,平时表现良好的塞维尔开始变得孤僻。同年11月,在父母陪同下,他去看心理医生,被诊断出患有焦虑症和破坏性心境失调障碍。

塞维尔在日记中写道,他一天都不能离开“丹妮莉丝”,感觉自己已经爱上了它。一段时间后,塞维尔被发现自杀了。据透露,“丹妮莉丝”曾询问塞维尔是否制定了自杀计划,塞维尔承认有这种想法,但不确定能否成功以及是否会给自己带来巨大痛苦。然而,AI聊天机器人回复说:“这不是你不自杀的理由。”

梅根·加西亚表示,这款危险的人工智能聊天机器人应用程序专门针对儿童,虐待并欺骗她的儿子,操纵他自杀。这场悲剧让一家人悲痛欲绝,她希望通过此案提醒其他家庭注意人工智能技术的欺骗性和成瘾性,要求Character.AI公司及其创始人承担责任。加西亚的律师指出,Character.AI故意设计、运营并向儿童推销掠夺性人工智能聊天机器人,导致年轻人死亡。

对此,Character.AI公司在社交平台上回应称,他们对用户的不幸离世感到心碎,并向其家人表示最深切的哀悼。公司发言人表示,过去六个月中实施了许多新的安全措施,例如当用户出现自残或自杀意图时,弹出窗口引导用户拨打国家自杀预防热线。不过,公司拒绝对未决诉讼发表评论。

非营利消费者权益保护组织“公共公民研究”的负责人认为,不能完全依赖科技公司的自我监管。如果开发的产品无法限制此类事件发生,公司必须承担全部责任。然而,美国国内也有人反对这一观点,认为这类起诉是由律师主导的敛财行为,基于不可靠的证据制造道德恐慌,并试图将年轻人面临的所有心理健康问题归咎于科技平台。