英伟达的“GPU狂热”才刚开始 全面AI热潮蓄势待发

英伟达的“GPU狂热”才刚开始

自从Open AI发布ChatGPT以来,生成式AI成为了科技领域的热门话题,英伟达的GPU作为AI芯片的重要组成部分受到追捧。然而,生产这些GPU时遇到了两个关键瓶颈:台积电的CoWoS技术和高带宽内存(HBM),导致全球GPU供应紧张。尤其是对H100型号的需求激增,其售价一度高达4万美元,引发了所谓的“GPU狂热”。英伟达的“GPU狂热”才刚开始。

面对这一情况,台积电通过增加产能,以及SK海力士等厂商提升HBM产量,使得H100的交货周期从一年缩短至半年左右。这不禁让人思考,英伟达的GPU短缺问题是否会随之缓解?

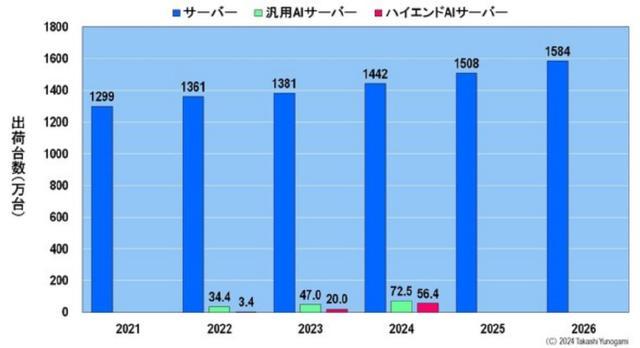

尽管生产效率有所提升,但预计到2024年,能够支持ChatGPT级别AI开发和运行的高端AI服务器出货量仅占所有服务器出货量的3.9%,这似乎远远不能满足谷歌、亚马逊、微软等云服务提供商的需求。由此可见,英伟达所经历的“GPU狂热”可能仅仅是个序幕,一个更广泛的生成式AI浪潮正蓄势待发。

在英伟达GPU的制造过程中,台积电扮演了核心角色,负责整个生产流程。其中,硅中介层(Interposer)的生产和扩大是提高GPU产能的关键,而HBM的供应同样受限于技术升级和市场需求的快速增长。为解决这些瓶颈,台积电扩大了硅中介层的产能,同时三星电子和美光科技也开始为英伟达提供先进的HBM,加入原本由SK海力士主导的供应链。

这些努力的结果是,H100的供应紧张状况得到了显著改善,然而,要满足市场对高端AI服务器的庞大需求,特别是那些运行ChatGPT级别的AI系统,仍然面临挑战。预计未来几年内,尽管高端AI服务器的出货量会持续增长,但相对于美国CSP的需求仍显不足。此外,谷歌和亚马逊等公司不仅作为英伟达的客户,也凭借自家的AI加速器(如谷歌的TPU)逐渐成为其有力的竞争者,这进一步加剧了市场的动态变化。

随着AI技术的飞速发展,特别是生成式AI的广泛应用,对高性能计算资源的需求将持续膨胀。尽管当前存在供应瓶颈,但长远看来,一个围绕数据中心和高级AI应用的全面扩张趋势已经显现,预示着一场更为广泛的人工智能热潮即将展开。

英伟达的“GPU狂热”才刚开始。